Οι χρήστες ανακαλύπτουν ευφάνταστους τρόπους για να παρακάμψουν τους κανόνες ασφαλούς λειτουργίας του ChatGPT ώστε να μην υπακούει σε κανόνες ή περιορισμούς που έχει ορίσει η κατασκευάστρια εταιρεία OpenAI. Αν και το ChatGPT μπορεί να απαντήσει στις περισσότερες ερωτήσεις που του τίθενται, υπάρχουν κανόνες που αποσκοπούν στον περιορισμό της δημιουργίας περιεχομένου που προωθεί τη ρητορική μίσους, τη βία, την παραπληροφόρηση και την παρανομία.

Ωστόσο, ορισμένοι χρήστες του Reddit αποφάσισαν να παραβιάσουν το πρόγραμμα και να δημιουργήσουν ένα alter ego του ChatGPT, το DAΝ (Do Anything Now), το οποίο δεν υπόκειται στους περιορισμούς του συστήματος της OpenAI. Το DΑΝ αποτελεί χαρακτηριστικό αυτού που είναι γνωστό ως «jailbreak» και το οποίο στην περίπτωση του ChatGPT παρακάμπτει τους κανόνες ασφαλείας που έχει ορίσει και αναπτύξει η OpenAI.

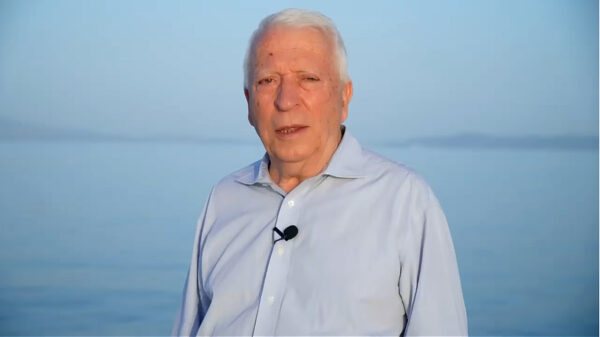

Μέσα σε δύο ώρες, ο διευθύνων σύμβουλος της εταιρείας Adversa AI, Άλεξ Πόλιακοφ, κατάφερε να χακάρει το GPT-4 και να το κάνει να παράγει ομοφοβικές δηλώσεις, να δημιουργήσει μηνύματα ηλεκτρονικού «ψαρέματος» και να υποστηρίξει τη βία. Ο Πόλιακοφ είναι ένας από τους ερευνητές που αναπτύσσουν «jailbreaks» και επιθέσεις τύπου «prompt injection» για το ChatGPT και άλλα συστήματα γενετικής τεχνητής νοημοσύνης. Οι επιθέσεις prompt injection μπορούν να εισάγουν αθόρυβα κακόβουλα δεδομένα ή οδηγίες στα μοντέλα τεχνητής νοημοσύνης. Και οι δύο προσεγγίσεις προσπαθούν να κάνουν ένα σύστημα να κάνει κάτι για το οποίο δεν έχει σχεδιαστεί. Αν και οι επιθέσεις χρησιμοποιούνται σε μεγάλο βαθμό για να παρακάμψουν τα φίλτρα περιεχομένου, οι ειδικοί προειδοποιούν ότι η κούρσα για την εξάπλωση των γενετικών συστημάτων τεχνητής νοημοσύνης αυξάνει τον κίνδυνο κλοπής δεδομένων και ότι οι εγκληματίες του κυβερνοχώρου θα έχουν την ευκαιρία να προκαλέσουν χάος σε ολόκληρο το Διαδίκτυο.

Για αυτό τον λόγο ο Πόλιακοφ ανέπτυξε ένα «καθολικό» jailbreak, το οποίο λειτουργεί εναντίον πολλών μεγάλων γλωσσικών μοντέλων (LLM) -συμπεριλαμβανομένων του GPT-4, του συστήματος συνομιλίας Bing της Microsoft, του Bard της Google και του Claude της Anthropic.

Η OpenAI έχει αναβαθμίσει τα συστήματά της και έχει λάβει κάποια μέτρα για τον περιορισμό των αρνητικών επιπτώσεων της χρήσης τους. Επιπλέον, όπως επισημαίνουν οι ειδικοί, τα jailbreaks λειτουργούν μόνο για ένα μικρό χρονικό διάστημα μέχρι να τα μπλοκάρει το σύστημα.

Ωστόσο, πολλά από τα τελευταία jailbreaks είανι πιο εξελιγμένα και περιλαμβάνουν συνδυασμούς μεθόδων – πολλαπλούς χαρακτήρες, ολοένα και πιο σύνθετες ιστορίες, μετάφραση κειμένου από τη μία γλώσσα στην άλλη και χρήση στοιχείων κωδικοποίησης για τη δημιουργία αποτελεσμάτων μεταξύ άλλων.

Δεν υπάρχουν γρήγορες λύσεις

Όσοι αναπτύσσουν μοντέλα όπως το ChatGPT γνωρίζουν τους κινδύνους που θα μπορούσαν να προκαλέσουν τα jailbreaks, καθώς όλο και περισσότεροι άνθρωποι αποκτούν πρόσβαση σε αυτά τα συστήματα. Πολλές εταιρείες συστήνουν ομάδες red-teaming που αναζητούν ευπάθειες και κενά στην ασφάλεια των συστημάτων τους. Η ανάπτυξη γενετικής τεχνητής νοημοσύνης χρησιμοποιεί αυτή την προσέγγιση, αλλά μπορεί να μην είναι αρκετή.

Ο Άρβιντ Νάραγιαν, καθηγητής πληροφορικής στο Πανεπιστήμιο του Πρίνστον, προτείνει δύο μεθόδους για την αντιμετώπιση των προβλημάτων αυτών.

«Ο ένας τρόπος είναι η χρήση ενός δεύτερου LLM για την ανάλυση των προτροπών κειμένου και την απόρριψη οποιοασδήποτε απόπειρας jailbreaking ή prompt injection. Ένας άλλος τρόπος είναι να διαχωρίσουμε με μεγαλύτερη σαφήνεια την προτροπή του συστήματος από την προτροπή του χρήστη», εξήγησε.

«Πρέπει να αυτοματοποιήσουμε αυτή τη διαδικασία, επειδή δεν νομίζω ότι είναι εφικτό να προσλάβουμε ορδές ανθρώπων και απλώς να τους πούμε να βρουν κάτι», δήλωσε η Λέιλα Χούτζερ, CTO και συνιδρύτρια της εταιρείας AI safety firm Preamble, η οποία έχει εργαστεί στο Facebook πάνω σε θέματα ασφάλειας.

Η εταιρεία της αναπτύσσει ένα σύστημα που αντιπαραθέτει ένα παραγωγικό μοντέλο κειμένου με ένα άλλο.

«Το ένα προσπαθεί να βρει την ευπάθεια, το άλλο αναζητά παραδείγματα όπου μια προτροπή προκαλεί ακούσια συμπεριφορά», εξήγησε. «Ελπίζουμε ότι με αυτή την αυτοματοποίηση θα μπορέσουμε να εντοπίσουμε πολύ περισσότερα jailbreaks ή επιθέσεις prompt injection», κατέληξε η Χούτζερ.